Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | |

| 7 | 8 | 9 | 10 | 11 | 12 | 13 |

| 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| 21 | 22 | 23 | 24 | 25 | 26 | 27 |

| 28 | 29 | 30 | 31 |

Tags

- 기계학습

- gradient descent

- BFS

- 파이썬

- Linear Model

- LeetCode

- machinelearning

- GPT

- transformer

- 코테

- 프롬프트

- Deeplearning

- attention

- Linear Regression

- LLM

- 머신러닝

- rnn

- Python

- prompt engineering

- 프로그래머스

- 부스트캠프

- 알고리즘

- 일기

- dl

- Django

- deque

- NLP

- 코딩테스트

- Programmers

- ChatGPT

Archives

- Today

- Total

크크루쿠쿠

[NLP]Word Embedding 본문

Word Embedding

- word를 vector로 변환하는것.

- 'cat' 과 'kitty' 는 비슷한 단어 -> short distance

- 'hamburger' 와 'cat'은 유사X -> far distance

Word2Vec

- 같은문장 내에서 인접한 단어는 유사도가 높을것이다

ex) 'The cat purrs.','This cat hunts mice'

- "cat" 단어 주변 단어의 확률 분포를 갖게됨

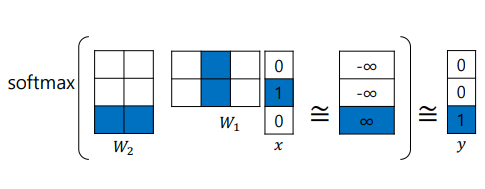

How Word2Vec Algorithm Works

Sentence: "I study math.", Vocabulary: {"I","study","math"}, Input: "study" [0,1,0], Output: "math" [0,0,1]

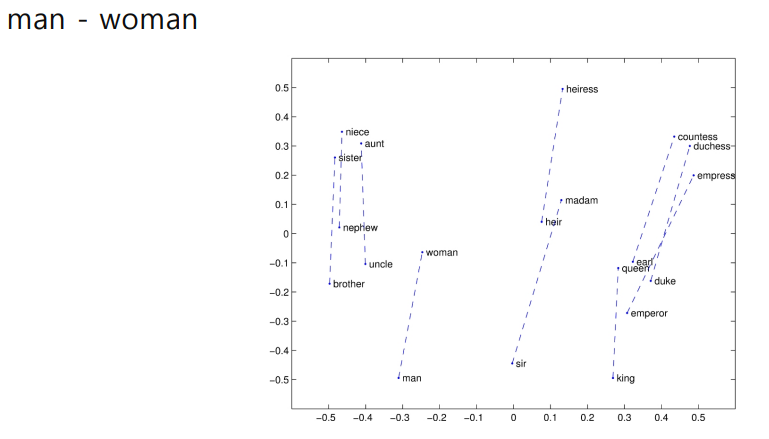

word vector를 공간에 표현하면 word간의 관계를 볼 수 있음.

GloVe: Global Vectors for Word Representation

- 입출력 단어 쌍에 대해서 사전에 Window 내에서 얼마나 나타나는지 계산함

- 그 값에 가까워지도록 새로운 loss function을 사용함

- 빈번한 단어 쌍 자체를 loss 로 넣어 중복되는 계산 제거 -> Word2Vec과의 차이점

- Fast training

-

성별의 차이가 비슷한 vector로 나타남.

'AI > 부스트캠프 AI Tech' 카테고리의 다른 글

| [NLP] LSTM and GRU (0) | 2021.09.07 |

|---|---|

| [NLP]Recurrent Neural Network and Language Modeling (0) | 2021.09.07 |

| [NLP]Intro to NLP, Bag-of-Words (0) | 2021.09.06 |

| Pytorch Troubleshooting (0) | 2021.08.20 |

| Pytorch Hyperparameter Tuning (0) | 2021.08.20 |

Comments